- Mail:

- info@digital4pro.com

Nuovi potenziali pericoli connessi all’intelligenza artificiale

IoT: LoRa per il monitoraggio ambientale

10 Settembre 2025

AI: L’impatto sull’organizzazione dell’impresa e sui posti di lavoro

23 Settembre 2025Introduzione

Come già sottolineato, l’intelligenza artificiale non apporta soltanto benefici in termini di cybersecurity. Infatti, questa tecnologia può essere sfruttata dai cybercriminali per perfezionare i loro attacchi ai danni delle organizzazioni.

Questa possibilità, secondo alcuni esperti, viene ulteriormente alimentata dal fatto che, come già osservato, il processo didigitalizzazione avvenuto negli ultimi anni ha reso le organizzazioni ancora più vulnerabili in termini di sicurezzainformatica[1].

Inoltre, un altro fattore che facilita tale fenomeno è il fatto che, in alcuni casi, questa tecnologia è open-source, per cui può essere rapidamente acquisita dagli hacker senza sostenere costi significativi.

Questi possono poi sviluppare sistemi di apprendimento automatico personalizzati, istruiti per arrecare danno alle persone e alle organizzazioni. Tali sistemi garantiscono anche l’anonimato degli hacker, con la conseguenza che saràpiù complesso individuare la persona che si trova alla guida di un certo cyberattacco. Le principali conseguenze negative correlate alla diffusione delle macchine intelligenti presso gli hacker secondo gli esperti sono[2] di seguito sintetizzate.

Espansione delle minacce esistenti

L’intelligenza artificiale presenta alcune caratteristiche vantaggiose quali la scalabilità, l’efficienza e la facilità di diffusione.

Di conseguenza, è possibile che vi sia un incremento degli attacchi complessivi, della loro frequenza e del numero delle vittime. In particolare, un cyberattacco che, secondo gli esperti, è destinato a diventare sempre più frequente è lo spearphishing, tramite il quale i cybercriminali inviano e-mail o altre comunicazioni elettroniche personalizzate, fingendo di essere amici o colleghi di lavoro di un certo individuo. Per riuscire a fare ciò, si sfrutta l’abilità delle macchine intelligentidi analizzare i comportamenti normalmente tenuti da un individuo sui social network. In questo modo, si riescono a ottenere informazioni sensibili, quali gli interessi privati e personali delle vittime[3].

Quindi si può affermare che l’intelligenza artificiale automatizza e velocizza la fase di ricerca e acquisizione delle informazioni private della vittima.

Successivamente, gli hacker possono avvalersi dei chatbot per ottenere la fiducia delle persone, grazie alla loro capacitàdi intrattenere lunghi colloqui con loro, come se fossero degli esseri umani. Una volta ottenuta la fiducia, i cybercriminaliinviano messaggi strettamente correlati al contesto lavorativo o privato della vittima per ingannarla. Vista la maggiore rapidità di questi sistemi nell’analisi degli interessi delle persone, gli esperti sostengono che lo spear phishing diventerà un attacco indirizzato a un numero sempre più crescente di individui.

Un esempio di questa pratica deriva da uno studio condotto su Twitter dalla ZeroFox, società di sicurezza informaticastatunitense. Infatti, alcuni ricercatori hanno dimostrato che un sistema automatizzato di spear phishing sarebbe in grado di generare rapidamente tweet personalizzati in base alle preferenze degli utenti, così da indurli a cliccare su link malevoli.

Introduzione di nuove minacce

i cybercriminali possono sfruttare le macchine intelligenti per effettuare nuove attività che loro da soli non erano in grado di eseguire, generando così nuove forme di attacco informatico. Inoltre, potrebbero anche individuare più facilmente le vulnerabilità dei sistemi difensivi adottati dalle organizzazioni, grazie alla loro tempestiva capacità di analisi[4].

In questo senso, l’intelligenza artificiale può essere impiegata per effettuare attacchi di social engineering sempre più sofisticati. L’ingegneria sociale è quella tecnica adottata dagli hacker per manipolare la mente delle persone, in modo tale da scoprire le password, violare i sistemi informatici e ottenere le informazioni personali di un individuo. Nello specifico, secondo gli studiosi, le macchine intelligenti hanno le potenzialità per rendere più frequenti ed efficaci eventi quali il furto d’identità e la penetrazione dei network personali.

A tal proposito, la capacità di creare immagini, testi scritti e tracce audio in grado di imitare la voce delle persone può essere sfruttata per impersonare altri individui mentre si è online, oppure per diffondere disinformazione.

Per esempio, i cybercriminali potrebbero attaccare i sistemi di Natural Language Processing per cambiare drasticamente i contenuti di un documento scritto[5]. Quest’ultimo aspetto è particolarmente significativo e può essere utilizzato per influenzare le scelte della popolazione durante una campagna elettorale per esempio. Sfruttando i social network, infatti, i sistemi di intelligenza artificiale possono creare numerosi account falsi che hanno lo scopo di diffondere le fake news.

Oltre a ciò, si possono generare virus intelligenti in grado di infettare i dispositivi elettronici senza farsi notare da chi li utilizza[6]. In questo senso, gli hacker potrebbero sviluppare malware in grado di alterare il funzionamento dei robot intelligenti utilizzati nel processo produttivo dalle organizzazioni, oppure delle auto con guida autonoma.

Nel primo caso, vi possono essere errori nei prodotti finiti, con conseguenti danni economici e reputazionali per le aziende.

Nel secondo caso, il malfunzionamento dei sistemi potrebbe impedire alle vetture di riconoscere i cartelli stradali, causando così degli incidenti. Infine, l’intelligenza artificiale, imitando la navigazione delle persone sul web, può sovraccaricare un servizio online, impedendo l’accesso agli individui autorizzati e consentendolo ai malintenzionati.

Modifica delle caratteristiche delle minacce

Gli hacker possono usufruire della capacità di apprendere dall’esperienza degli algoritmi per perfezionare i loro attacchi e renderli sempre più efficaci, personalizzati e difficili da individuare. Come già sottolineato, i cyberattacchi saranno sempre più numerosi e frequenti, viste le caratteristiche di efficienza e scalabilità possedute dall’intelligenza artificiale. Inalcuni casi saranno anche più efficaci, in quanto, talvolta, le macchine intelligenti possono superare le abilità cognitive degli esseri umani. Inoltre, gli attacchi informatici potranno essere anche più mirati verso gli obiettivi desiderati. A talproposito, gli algoritmi di machine learning riescono a individuare le vittime più appetibili in relazione ai loro comportamenti online e alla loro disponibilità a pagare eventuali riscatti in caso di ransomware. Quest’ultimo è softwaremalevolo in grado di infettare i dispositivi elettronici e di impedire il loro funzionamento, fino a quando la vittima non paga un riscatto in denaro. Infine, come già affermato, l’intelligenza artificiale consente al cybercriminale di mantenere un elevato livello di anonimato.

Principali cyberattacchi basati sull’intelligenza artificiale

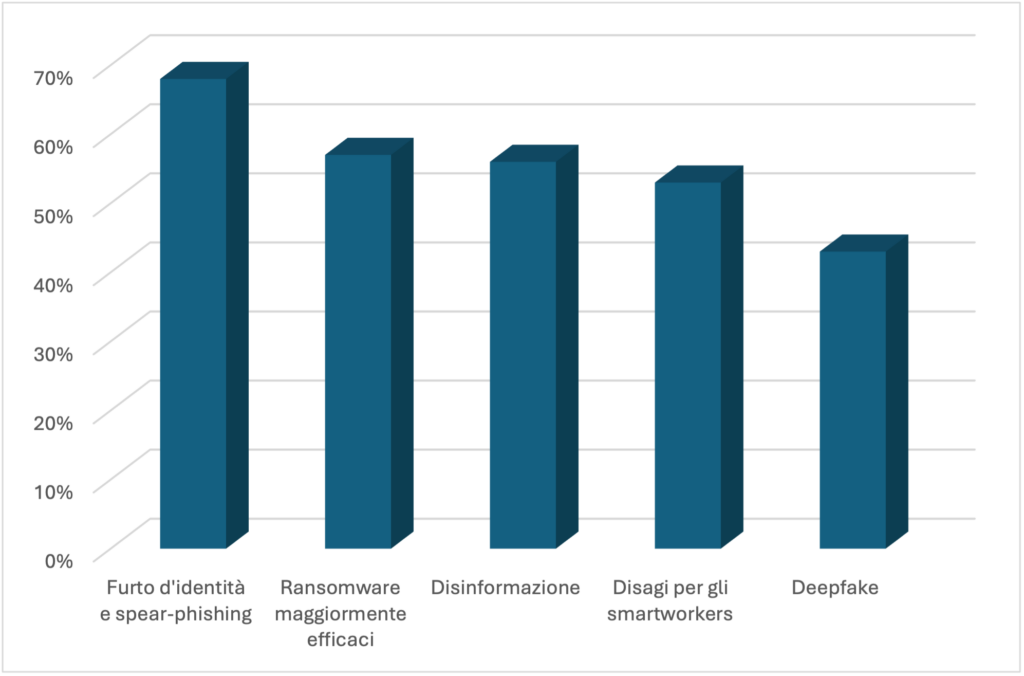

Secondo un sondaggio che ha coinvolto alcuni business leader delle organizzazioni, i cyberattacchi che saranno maggiormente favoriti dall’intelligenza artificiale sono i seguenti:

Figura 1 – Principali cyberattacchi basati sull’intelligenza artificiale[7].

Questi dati confermano quanto sostenuto dagli esperti. Infatti, lo spear-phishing, insieme al furto d’identità, si propone come la tipologia di cyberattacco più facilitata dall’intelligenza artificiale. Seguono i ransomware, la disinformazione, gli attacchi contro i lavoratori a distanza e il deepfake. Con quest’ultima espressione si indica una tecnica utilizzata per sovrapporre l’immagine o il video di una persona ad un’altra in una fotografia oppure in un video. Essa determina unaperdita di controllo sulla propria immagine e sulle proprie idee, le quali possono essere modificate in base a discorsi falsi che vengono espressi in video creati al computer.

Conclusioni

Sulla base di quanto esposto, si può affermare che l’intelligenza artificiale costituisce una minaccia significativa per la sicurezza informatica delle organizzazioni.

Per mitigare gli effetti negativi correlati all’uso malevole di questa tecnologia, può essere opportuno prendere alcune contromisure[8]: innanzitutto, è auspicabile che vi sia una collaborazione tra policy maker e ricercatori tecnici, in maniera tale da prevenire e mitigare l’utilizzo malevole delle macchine intelligenti; inoltre, coloro che sviluppano i sistemi di intelligenza artificiale dovrebbero acquisire consapevolezza in merito alla duplice natura di questi sistemi, in maniera tale da segnalare tutti quei casi in cui vengono realizzate tecnologie potenzialmente dannose per la cybersecurity; infine, è necessario promuovere un’ampia attività di formazione volta a sviluppare consapevolezza sulle minacce informatiche che possono colpire le organizzazioni e le persone.

Occorre poi sottolineare che alcuni impieghi delle macchine intelligenti generano sia vantaggi che rischi a livello dicybersecurity. Per esempio, gli algoritmi di machine learning vengono utilizzati dalle organizzazioni per individuare le possibili caratteristiche dei malware che in futuro le attaccheranno; allo stesso tempo, i cybercriminali possono sfruttarliper effettuare attacchi mirati e personalizzati in funzione delle caratteristiche delle vittime. Di conseguenza, ècomplesso stabilire a priori se questa tecnologia si presta prevalentemente a utilizzi benevoli o malevoli. La questione è piuttosto problematica e in costante evoluzione. La cosa certa secondo molti esperti è che l’intelligenza artificiale verrà progressivamente impiegata sia per potenziare i sistemi difensivi che per ottimizzare gli attacchi. Soltanto nei prossimi anni sarà possibile determinare se saranno maggiori i benefici oppure i rischi. Nonostante l’apparente situazione di incertezza, secondo alcuni esperti, la soluzione migliore per difendersi da cyberattacchi basati sull’intelligenza artificiale è rappresentata dalle macchine intelligenti stesse. Questo perché gli esseri umani non hanno la capacità di prevedere con accuratezza le modalità tramite cui i sistemi intelligenti intendono attaccare le difese delleorganizzazioni[9].

| PRINCIPALI VANTAGGI | PRINCIPALI RISCHI |

| Riduzione dei costi necessari per rilevaree rispondere ad un cyberattacco | Garanzia di maggiore anonimato per i cybercriminali |

| Diminuzione delle tempistiche necessarieper rilevare e rispondere ad uncyberattacco | Incrementi nel numero e nella frequenzadei cyberattacchi |

| Incremento dell’accuratezza nellarilevazione dei cyberattacchi | Potenziamento dello spear phishing |

| Classificazione automatizzata dei cyber-rischi | Ottimizzazione degli attacchi di social engineering |

| Monitoraggio continuo sull’attività dei dipendenti | Possibile sviluppo di malware e virus intelligenti |

| Automatizzazione delle attività disicurezza di routine | Opportunità di individuare più facilmentele aree vulnerabili dei sistemi di sicurezza organizzativi |

| Miglioramenti nella rilevazione deimalware | Cyberattacchi personalizzati e più efficaci |

| Maggiore accuratezza nella previsione dei virus futuri | Potenziamento ransomware |

| Ottimizzazione della rilevazione diintrusioni

nei server aziendali |

Disinformazione |

| Potenziamento della rilevazione di frodi | |

| Filtraggio automatico delle e-mail | |

Tabella 1 – Principali vantaggi e rischi correlati all’impiego dell’intelligenza artificiale nella cybersecurity[10].

Bibliografia

- Agrawal, A., Gans, J., & Goldfarb, A. (2017). The trade-off every AI company will face.

- Harvard Business Review Digital Articles.

- Aspan, M. (2020). Siri, Did I Ace the Interview? Fortune International (Europe), 181(2).

- Bhimani, A., & Willcocks, L. (2014). Digitisation, Big Data and the transformation of accounting information. Accounting and Business Research, Taylor & Francis, Vol. 44 No. 4.

- Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … & Amodei, D. (2018). The malicious use of artificial intelligence: Forecasting, prevention, and mitigation. arXiv preprint arXiv:1802.07228.

- CGMA (2016). Business Analytics And Decision Making. Baseline.

- Costa, G., & Gianecchini, M. (2019). Risorse umane: persone, relazioni e valore (Vol. 454). McGraw-Hill.

- Craigen, D., Diakun-Thibault, N., & Purse, R. (2014). Defining cybersecurity. Technology Innovation Management Review, 4(10).

- Daft, R. L. (2017). Organizzazione aziendale. Sesta edizione. Daft, R. L. (2021). Organizzazione aziendale. Maggioli, Milano.

- Davenport, T., Guha, A., & Grewal, D. (2021). How to Design an AI Marketing Strategy: What the Technology Can Do Today—and What’s Next. Harvard Business Review, 99, 42- 47.

- Davenport, T., Guha, A., Grewal, D., & Bressgott, T. (2020). How artificial intelligence will change the future of marketing. Journal of the Academy of Marketing Science, 48(1), 24- 42.

- Doke, D. (2021). Software AI. Recruiter.

- Forger, G. (2020). AI and IoT are ready for your warehouse. Logistics management (Highlands Ranch, Colo.: 2002).

- Fountaine, T., McCarthy, B., & Saleh, T. (2021). Getting AI to scale. Harvard Business Review.

- Galeotti, M., & Garzella, S. (Eds.). (2013). Governo strategico dell’azienda: Prefazione del Prof. Umberto Bertini. G Giappichelli Editore.

- Gambhir, B., & Bhattacharjee, A. (2021). Embracing the role of artificial intelligence in accounting and finance: contemplating the changing skillset expectations. Development and Learning in Organizations: An International Journal.

- Gregg, M. (2005). CISSP security-management practices. Upper Saddle River, NJ: Pearson Education.

- Haenlein, M., & Kaplan, A. (2019). A brief history of artificial intelligence: On the past, present, and future of artificial intelligence. California management review, 61(4), 5-14.

- Harrison, N., & O’Neill, D. (2017). If your company isn’t good at analytics, it’s not ready for AI. Harvard Business Review.

- Henke, N., Levine, J., & McInerney, P. (2018). You don’t have to be a data scientist to fill this must-have analytics role. Harvard Business Review.

- Huang, M. H., Rust, R., & Maksimovic, V. (2019). The feeling economy: Managing in the next generation of artificial intelligence (AI). California Management Review, 61(4), 43-65.

- Lichtenthaler, U. (2020). Mixing data analytics with intuition: Liverpool Football Club scores with integrated intelligence. Journal of Business Strategy.

- Luo, X., Qin, M. S., Fang, Z., & Qu, Z. (2021). Artificial intelligence coaches for sales agents: Caveats and solutions. Journal of Marketing, 85(2), 14-32.

- McAfee, A., & Brynjolfsson, E. (2012). Big data: the management revolution. Harvard business review, 90(10), 60-68.

- Miyashita, M., & Brady, M. (2019). The Health Care Benefits of Combining Wearables and AI. Harvard Business Review.

- Nair, K., & Gupta, R. (2021). Application of AI technology in modern digital marketing environment. World Journal of Entrepreneurship, Management and Sustainable Development.

- Niehueser, W., & Boak, G. (2020). Introducing artificial intelligence into a human resources function. Industrial and commercial training, 52(2), 121-130.

- Ore, O., & Sposato, M. (2021). Opportunities and risks of artificial intelligence in recruitment and selection. International Journal of Organizational Analysis.

- Paschen, J., Kietzmann, J., & Kietzmann, T. C. (2019). Artificial intelligence (AI) and its implications for market knowledge in B2B marketing. Journal of Business & Industrial Marketing.

- Paschen, U., Pitt, C., & Kietzmann, J. (2020). Artificial intelligence: Building blocks and an innovation typology. Business Horizons, 63(2), 147-155.

- Petkov, R. (2020). Artificial intelligence (AI) and the accounting function—A revisit and a new perspective for developing framework. Journal of emerging technologies in accounting, 17(1), 99-105.

- Pighin, M., & Marzona, A. (2018). Sistemi informativi aziendali: ERP e sistemi di data analysis.

- Poba-Nzaou, P., Galani, M., Uwizeyemungu, S., & Ceric, A. (2021). The impacts of artificial intelligence (AI) on jobs: an industry perspective. Strategic HR Review, 20(2), 60- 65.

- Ponnapalli, P. (2022). Keys to successful innovation through artificial intelligence. Harvard Business Review.

- Ransbotham, S., Candelon, F., Kiron, D., LaFountain, B., & Khodabandeh, S. (2021). The Cultural Benefits of Artificial Intelligence in the Enterprise. MIT Sloan Management Review and Boston Consulting Group.

- Rudko, I., Bashirpour Bonab, A., & Bellini, F. (2021). Organizational structure and artificial intelligence. Modeling the intraorganizational response to the ai contingency. Journal of Theoretical and Applied Electronic Commerce Research, 16(6), 2341-2364.

- Samonas, S., & Coss, D. (2014). The CIA strikes back: Redefining confidentiality, integrity and availability in security. Journal of Information System Security, 10(3).

- Shrestha, Y. R., Ben-Menahem, S. M., & Von Krogh, G. (2019). Organizational decision- making structures in the age of artificial intelligence. California Management

- Review, 61(4), 66-83.

- Simonovich, L. (2021). Balancing AI advances with robust cybersecurity solutions. World Oil.

- Soni, V. D. (2020). Challenges and Solution for Artificial Intelligence in Cybersecurity of the USA. Available at SSRN 3624487.

- Strubell, E., Ganesh, A., & McCallum, A. (2019). Energy and policy considerations for deep learning in NLP. arXiv preprint arXiv:1906.02243.

- Tabesh, P. (2021). Who’s making the decisions? How managers can harness artificial intelligence and remain in charge. Journal of Business Strategy.

- S (2021). 3 areas where AI will boost your competitive advantage. Harvard Business Review Digital Articles.

- Truong, T. C., Zelinka, I., Plucar, J., Čandík, M., & Šulc, V. (2020). Artificial intelligence and cybersecurity: Past, presence, and future. In Artificial intelligence and evolutionary computations in engineering systems (pp. 351-363). Springer, Singapore.

- Tschang, F. T., & Almirall, E. (2021). Artificial intelligence as augmenting automation: Implications for employment. Academy of Management Perspectives, 35(4), 642-659.

- Tse, T., Esposito, M., Takaaki, M., & Goh, D. (2020). The dumb reason your AI project will fail. Harvard business review digital articles, 2-5.

- Vadari, S., & Desik, P. A. (2021). The Role of AI/ML in Enhancing Knowledge Management Systems. IUP Journal of Knowledge Management, 19(2), 7-31.

- Wamba-Taguimdje, S. L., Wamba, S. F., Kamdjoug, J. R. K., & Wanko, C. E. T. (2020). Influence of artificial intelligence (AI) on firm performance: the business value of AI-based transformation projects. Business Process Management Journal, 26(7), 1893-1924.

- Whitmore, A., Agarwal, A., & Da Xu, L. (2015). The Internet of Things—A survey of topics and trends. Information systems frontiers, 17(2), 261-274.

- Yampolskiy, R. V. (2017). AI Is the Future of Cybersecurity, for Better and for Worse. Harvard Business Review. May, 8.

- Zaki, M., McColl-Kennedy, R., & Neely, A. (2021). Using AI to Track How Customers Feel—In Real Time. Harvard Business Review.

- Zhang, H., Zhang, X., & Song, M. (2021). Deploying AI for New Product Development Success: By embracing and incorporating AI in all stages of NPD, companies can increase their success rate of NPD projects. Research-Technology Management, 64(5), 50-57.

- Zouave, E., Gustafsson, T., Bruce, M., Colde, K., Jaitner, M., & Rodhe, I. (2020). Artificially intelligent cyberattacks. Swedish Defence Research Agency, FOI, Tech. Rep. FOI.

- (2017). Lavazza a caccia di “coffe addicted” con l’intelligenza artificiale. Il Sole 24 Ore. Retrieved fromhttps://www.ilsole24ore.com/art/lavazza-caccia-coffee-addicted-l- intelligenza-artificiale–AEBRpxQD 2022/08/02

- Amar, J., Majumder, S., Surak, Z., & von Bismarck, N. (2021). How AI-driven nudges can transform an operation’s performance. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/operations/our-insights/how-ai-driven- nudges-can-transform-an-operations-performance 2022/07/27

- Balabio, B., Orlando, P., & Scolari, T. (2021). Cresce il mercato dell’intelligenza artificiale in Italia. Retrieved from https://www.osservatori.net/it/ricerche/comunicati- stampa/artificial-intelligence-italia-mercato-progetti-20202022/07/08

- Berruti, F., Nel, P., & Whiteman R. (2020). An executive primer on artificial general intelligence. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/operations/our-insights/an-executive- primer-on-artificial-general-intelligence 2022/07/06

- Boehm, J., Curcio, N., Merrath, P., Shenton, L., & Stahle T. (2019). The risk-based approach to cybersecurity. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/risk-and-resilience/our-insights/the-risk- based-approach-to-cybersecurity 2022/08/03

- Brooks, C. (2022). Alarming cyber statistics for mid-year 2022 that you need to know. Forbes. Retrieved from https://www.forbes.com/sites/chuckbrooks/2022/06/03/alarming- cyber-statistics-for-mid-year-2022-that-you-need-to-know/?sh=7043d0247864 2022/08/03

- Brown, S., Gandhi, D., Herring, L., & Puri, A. (2019). The analytics academy: bridging the gap between human and artificial intelligence. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/mckinsey-analytics/our-insights/the- analytics-academy-bridging-the-gap-between-human-and-artificial-intelligence 2022/07/18

- Buehler, K., Dooley, R., Grennan, L., & Singla, A. (2021). Getting to know-and manage- your biggest AI risks. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/mckinsey-analytics/our-insights/getting-to- know-and-manage-your-biggest-ai-risks 2022/07/11

- Bughin, J., Seong, J., Manyika, J., Chui, M., & Joshi, R. (2018). Notes from the AI frontier: Modeling the impact of AI on the world economy. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/featured-insights/artificial-intelligence/notes-from-the-ai- frontier-modeling-the-impact-of-ai-on-the-world-economy#part12022/07/15

- Chakraborty, A. (2021). A.I. can be a cornerstone of success – but only if leaders make the right choices. Fortune. Retrieved from https://fortune.com/2021/10/27/ai-artificial- intelligence-business-strategy-data-accenture/2022/07/29

- Chui, M., Hall, B., Singla, A., & Sukharevsky, A. (2021). The state of AI in 2021. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business- functions/quantumblack/our-insights/global-survey-the-state-of-ai-in-20212022/07/08

- Chui, M., Manyika, J., Miremadi, M., Henke, N., Chung, R., Nel, P., & Malhotra, S. (2018). Notes from the AI frontier: Applications and value of deep learning. McKinsey global institute discussion paper, April. Retrieved from https://www.mckinsey.com/featured- insights/artificial-intelligence/notes-from-the-ai-frontier-applications-and-value-of-deep- learning 2022/07/07

- Dandona, G. S., Sharma, J., & Wright, M. (2021). Our own digital journey: upskilling hundreds of McKinsey technologists in AI. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/about-us/new-at-mckinsey-blog/ai-upskilling-for-over-500- firm-technologists 2022/07/19

- Fowler, G. (2020). AI and its potential for cybersecurity. Forbes. Retrieved from https://www.forbes.com/sites/forbesbusinessdevelopmentcouncil/2020/12/18/ai-and-its- potential-for-cybersecurity/?sh=5d2f609e69d9 2022/08/03

- https://assets.siemens-energy.com/siemens/assets/api/uuid:cf20f2e1-ca9c-4589-9f88- 4e6592b4672d/brochure-deeparmour-industrial-200609.pdf 2022/08/05

- https://bids.berkeley.edu/news/berkeley-institute-data-science-and-accenture-applied- intelligence-announce-new-collaboration 2022/07/18

- https://info.algorithmia.com/hubfs/2020/Reports/2021-Trends-in- ML/Algorithmia_2021_enterprise_ML_trends.pdf?hsLang=en-us 2022/07/08

- https://wwd.com/business-news/technology/levis-ai-bootcamp-data-science-1234881378/ 22/09/04

- https://www.accenture.com/_acnmedia/PDF-63/Accenture-CoBE-Brochure-

- pdf#zoom=50 2022/08/23

- https://www.accenture.com/fr-fr/_acnmedia/36dc7f76eab444cab6a7f44017cc3997.pdf 2022/07/08

- https://www.bcg.com/publications/2020/is-your-company-embracing-full-potential-of- artificial-intelligence 2022/09/17

- https://www.capgemini.com/wp-content/uploads/2019/07/AI-in- pdf 2022/08/03

- https://www.careers.ox.ac.uk/article/the-pymetrics-games-overview-and-practice- guidelines 2022/07/26

- https://www.cnr.it/sites/default/files/public/media/attivita/editoria/VOLUME%20FULL%20 14%20digital%20LIGHT.pdf 2022/08/22

- https://www.levistrauss.com/2021/05/17/machine-learning-bootcamp/ 2022/07/19

- https://www.linkedin.com/pulse/how-coca-cola-using-ai-stay-top-soft-drinks-market- shivani-salunkhe 2022/08/23

- https://www.mckinsey.com/about-us/new-at-mckinsey-blog/mckinsey-receives-top- ranking-in-the-forrester-wave-ai-report 2022/07/19

- https://www.nist.gov/system/files/documents/cyberframework/cybersecurity-framework- pdf 2022/08/03

- https://www.statista.com/statistics/1083482/worldwide-ai-revenue-increase/ 2022/08/02 https://www.statista.com/statistics/1083516/worldwide-ai-cost-decrease/ 2022/08/02

- https://www.statista.com/statistics/1119824/global-business-and-hr-leaders-on-ai-impact- to-job-numbers/ 2022/07/20

- https://www.statista.com/statistics/1235395/worldwide-ai-enabled-cyberattacks- companies/ 2022/08/05

- https://www.statista.com/statistics/1293758/ai-marketing-revenue-worldwide/ 2022/07/25

- https://www.statista.com/statistics/472934/business-analytics-software-revenue- worldwide/ 2022/07/29

- https://www.statista.com/statistics/871513/worldwide-data-created/ 2022/07/29

- https://www.statista.com/statistics/941137/ai-investment-and-funding-worldwide/ 2022/07/08

- https://www.treccani.it/enciclopedia/intelligenza-artificiale 2022/07/04

- https://www.treccani.it/enciclopedia/sicurezza-informatica/#:~:text=sicur%C3%A9zza%20inform%C3%A0tica%20Ramo%20dell’informatica,dati%20riservati%20in%20essi%20contenuti. 2022/09/13

- https://www.tripwire.com/state-of-security/security-data-protection/43-billion-stolen- through-business-email-compromise-since-2016-reports-fbi/ 2022/09/13

- https://www.webfx.com/martech/pricing/ai/#:~:text=In%202020%2C%20companies%20can%20pay,house%20or%20freelance%20data%20scientists.&text=In%20comparison

- %2C%20custom%20AI%20solutions,from%20%246000%20to%20over%20%24300%2C 000. 2022/09/18

- Jeans, D. (2020). Companies will spend $50 billion on artificial intelligence this year with little to show for it. Forbes. Retrieved from https://www.forbes.com/sites/davidjeans/2020/10/20/bcg-mit-report-shows-companies- will-spend-50-billion-on-artificial-intelligence-with-few-results/?sh=7efe3fe57c87 2022/09/17

- Johar, P. (2020). How AI makes big data smarter. Forbes. Retrieved from https://www.forbes.com/sites/forbestechcouncil/2020/03/23/how-ai-makes-big-data- smarter/?sh=381f9b6a4684 2022/08/01

- Luchtenberg, D., & Migliorini, R. (2022). Coca-Cola: The people-first story of a digital transformation. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/business-functions/operations/our-insights/coca-cola-the-people-first-story-of-a-digital-transformation 2022/08/02

- Malins, A. (2022). Machine learning and artificial intelligence: implementation in practice. Forbes. Retrieved from https://www.forbes.com/sites/forbestechcouncil/2022/01/25/machine-learning-and- artificial-intelligence-implementation-in-practice/?sh=7692b2a35c89 2022/07/15

- Manyika J., & Sneader K. (2018). AI, automation, and the future of work: Ten things to solve for. McKinsey Global Institute. Retrieved from https://www.mckinsey.com/featured- insights/future-of-work/ai-automation-and-the-future-of-work-ten-things-to-solve-for 2022/07/15

- Marr, B. (2017). The Amazing Ways Coca Cola Uses Artificial Intelligence And Big Data To Drive Success. Forbes. Retrieved from https://www.forbes.com/sites/bernardmarr/2017/09/18/the-amazing-ways-coca-cola- uses-artificial-intelligence-ai-and-big-data-to-drive-success/?sh=1448c01778d2 2022/08/02

- Marr, B. (2018). The amazing ways how Unilever uses artificial intelligence to recruit & train thousands of employees. Forbes. Retrieved from https://www.forbes.com/sites/bernardmarr/2018/12/14/the-amazing-ways-how-unilever-uses-artificial-intelligence-to-recruit-train-thousands-of-employees/?sh=485a1ca76274 2022/07/26

- Marr, B. (2022). The most in – demand technical skills – and how to develop them. Forbes. Retrieved from https://www.forbes.com/sites/bernardmarr/2022/08/03/the-most- in-demand-technical-skills–and-how-to-develop-them/?sh=7a1c4e1362e4 2022/08/22

- Mohan S. (2022). How to make it easier to implement AI in your business. Forbes. Retrieved from https://www.forbes.com/sites/forbestechcouncil/2022/05/27/how-to- make-it-easier-to-implement-ai-in-your-business/?sh=481bfbd65300 2022/07/12

- Rossitto, S. (2021). “Senza intelligenza artificiale e big data impossibile un vaccino contro il Covid in tempi brevi”. Il Sole 24 Ore. Retrieved from https://www.ilsole24ore.com/art/senza-intelligenza-artificiale-e-big-data-impossibile-vaccino-contro-covid-tempi-brevi-AD5lOYHB 2022/08/01

- Rusconi, G. (2022). L’intelligenza artificiale facilita il cambiamento organizzativo. Il Sole 24 Ore. Retrieved from https://www.ilsole24ore.com/art/l-intelligenza-artificiale-facilita- cambiamento-organizzativo-AEitC2OB 2022/07/14

- Sinur, J., & Peters, E. (2019). AI & big data; better together. Forbes. Retrieved from https://www.forbes.com/sites/cognitiveworld/2019/09/30/ai-big-data-better- together/?sh=61a9e9a360b3 2022/08/01

- Taulli, T. (2021). Artificial intelligence: should you teach it to your employees? Forbes. Retrieved from https://www.forbes.com/sites/tomtaulli/2021/09/10/ai-artificial- intelligence-should-you-teach-it-to-your-employees/?sh=2bab6b507b73 2022/07/18

- Tremolada, L. (2019). Machine learning, deep learning e reti neurali. Ecco di cosa parliamo. Il sole 24 ore. Retrieved from https://www.ilsole24ore.com/art/machine- learning-deep-learning-e-reti-neurali-ecco-cosa-parliamo–AEaToEBH2022/07/07

- ASIMOV, I. (1950), I, Robot. (Cited at page 5)

- BABBAGE, C. (1982), «On the Mathematical Powers of the Calculating Engine», The Origins of Digital Computers. Texts and Monographs in Computer Science.

- BODEN, M. A. (2018), Artificial Intelligence: A Very Short Introduction.

- CAMPBELL, M., HOANE, A. J. e HSIUNG HSU, F. (2002), «Deep Blue», Artificial Intelligence, vol. 134, p. 57–83.

- CLARKE, A. C. e KUBRICK, S. (1968), 2001: A Space Odyssey.

- DICK, P. K. (1968), Do Androids Dream of Electric Sheep?

- HASHEMIPOUR, S. e ALI, M. (2020), «Amazon Web Services (AWS) – An Overview of the On-Demand Cloud Computing Platform».

- KRIZHEVSKY, A., SUTSKEVER, I. e HINTON, G. E. (2012), «ImageNet classification with deep convolutional neural networks», Communications of the ACM, vol. 60, p. 84 – 90.

- LECUN, Y., BENGIO, Y. e HINTON, G. E. (2015), «Deep Learning», Nature, vol. 521, p. 436–444.

- MASLEJ, N., FATTORINI, L., BRYNJOLFSSON, E., ETCHEMENDY, J., LIGETT, K., LYONS, T., MANYIKA, J., NGO, H., NIEBLES, J. C., PARLI, V., SHOHAM, Y., WALD, R., CLARK, J., e PERRAULT, R. (2023), «The AI Index 2023 Annual Report», Rap. tecn., AI Index Steering Committee, Institute for Human-Centered AI, Stanford University, Stanford, CA.

- MCCARTHY, J. (1960), «Programs with common sense».

- MCCARTHY, J., MINSKY, M., ROCHESTER, N. e SHANNON, C. E. (2006), «A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, August 31, 1955», AI Mag., vol. 27, p. 12–14.

- RAO, A. S. e VERWEIJ, G. (2017), «Sizing the prize: what’s the real value of AI for your business and how can you capitalise?».

- RUSSELL, B. e WHITEHEAD, A. N. (1956), «Principia Mathematica to *56».

- RUSSELL, S. e NORVIG, P. (1995), «Artificial intelligence – a modern approach: the intelligent agent book».

- TURING, A. (1937), «On computable numbers, with an application to the Entscheidungsproblem», Proc. London Math. Soc.

- VASWANI, A., SHAZEER, N. M., PARMAR, N., USZKOREIT, J., JONES, L., GOMEZ, A. N., KAISER, L. e POLOSUKHIN, I. (2017), «Attention is All you Need», in «NIPS».

Note

[1] Simonovich, L. (2021). Balancing AI advances with robust cybersecurity solutions. World Oil, 55.

[2] Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … & Amodei, D. (2018), op. cit., 18- 29.

[3] Zouave, E., Gustafsson, T., Bruce, M., Colde, K., Jaitner, M., & Rodhe, I. (2020). Artificially intelligent cyberattacks. Swedish Defence Research Agency, FOI, Tech. Rep. FOI, 25.

[4] Zouave, E., Gustafsson, T., Bruce, M., Colde, K., Jaitner, M., & Rodhe, I. (2020), op. cit., 21.

[5] Zouave, E., Gustafsson, T., Bruce, M., Colde, K., Jaitner, M., & Rodhe, I. (2020), op. cit., 29.

[6] Yampolskiy, R. V. (2017). AI Is the Future of Cybersecurity, for Better and for Worse. Harvard Business Review. May, 8, 2.

[7] https://www.statista.com/statistics/1235395/worldwide-ai-enabled-cyberattacks-companies/ 2022/08/05.

[8] Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … & Amodei, D. (2018), op. cit., 18.

[9] Yampolskiy, R. V. (2017), op. cit., 2-3.

[10] Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … & Amodei, D. (2018), op. cit.; Fowler, G. (2020), op. cit.; Yampolskiy, R. V. (2017), op. cit.).